index●comunicación | nº 13(1) 2023 | Páginas 79-103

E-ISSN: 2174-1859 | ISSN: 2444-3239 | Depósito Legal: M-19965-2015

Recibido el 14_09_2022 | Aceptado el 31_10_2022 | Publicado el 15_01_2023

Comunicación académica y buscadores científicos: ‘Scoping Review’

Scholarly Communication and Scientific Search Engines: Scoping Review

https://doi.org/10.33732/ixc/13/01Comun2

Pastor-Ramon, Elena

Biblioteca Virtual de Ciències de la Salut de les Illes Balears (Bibliosalut). Universitat Pompeu Fabra

https://orcid.org/0000-0003-2609-6541

Cristòfol Rovira

Universitat Pompeu Fabra

https://orcid.org/0000-0002-6463-3216

Este trabajo forma

parte del proyecto "Parámetros y estrategias para incrementar la

relevancia de los medios

y la comunicación digital en la sociedad: curación, visualización y visibilidad

(CUVICOM)”.

PID2021-123579OB-I00 (MICINN), Ministerio de Ciencia e Innovación (España).

![]() Para citar este trabajo: Pastor-Ramon, E. y Rovira, C. (2023). Comunicación

académica y buscadores científicos: ‘Scoping Review’. index.comunicación, 13(1),

79-103. https://doi.org/10.33732/ixc/13/01Comun2

Para citar este trabajo: Pastor-Ramon, E. y Rovira, C. (2023). Comunicación

académica y buscadores científicos: ‘Scoping Review’. index.comunicación, 13(1),

79-103. https://doi.org/10.33732/ixc/13/01Comun2

Resumen: El desarrollo científico necesita comunicar la investigación. La comunicación académica ha evolucionado debido a diferentes presiones, pero también ha quedado afectada por los sistemas de las bases de datos y otros sistemas de información. Esta scoping review lleva a cabo un análisis de cómo percibe la academia la influencia de bases de datos como Web of Science y Scopus, que se basan en sus propias colecciones de revistas, y otras bases de datos basadas en la búsqueda web de citas como Google Scholar, Dimensions y The Lens. Se realizó una búsqueda bibliográfica en las bases de datos Lista, WoS y Scopus sobre artículos científicos que mencionaran la comunicación académica y se centrasen en los recursos analizados. Se limitó la búsqueda a los años 2016-2021 y a los idiomas español, inglés, catalán, francés, italiano y portugués. Las bases de datos bibliográficas como WoS y Scopus siguen dando una imagen sesgada de la influencia de las investigaciones, y otras herramientas, como GS y Dimensions, son recursos que todavía presentan claroscuros por no permitir la réplica de las búsquedas o la descarga de los datos, como GS, por ejemplo. Por esto se recomienda a los investigadores el uso combinado de diferentes sistemas de información.

Palabras clave: Comunicación académica; buscadores académicos; investigación; producción científica; citas; bibliometría.

Abstract: To enable scientific development, research must be communicated. Scholarly communication has evolved over the years, but not the way how researchers have to justify their scientific output. This scoping review aims to describe the situation of the main scientific search engines Web of Science and Scopus, which are based on their own journal collections, and others based on citation web searches such as Google Scholar, Dimensions, and The Lens. A bibliographic search was carried out in the Lista, WoS, and Scopus databases for scientific articles dealing with scholarly communication and focusing on the resources analyzed. The search was limited to the years 2016-2021 and to the languages Spanish, English, Catalan, French, Italian and Portuguese. Bibliographic databases such as WoS and Scopus continue giving a biased picture of the influence of research, and web-based tools, such as GS and Dimensions, are resources that still have many shortcomings for not allowing the replication of searches or downloading of data, e.g., by GS. It is therefore recommended to use as much information as possible to have a more complete picture of the care received.

Keywords: Scholar Comunication; Scientific Search Engines; Research, Scientific Production; Cites; Bibliometry.

1. Introducción

La comunicación académica es una de las claves principales del desarrollo científico porque una investigación que no se comunica, no existe. Por eso, autores e investigadores utilizan bases de datos y sistemas de información documentales para fundamentar sus trabajos (Burghardt et al., 2020; Wilder & Walters, 2021).

Es a mediados de la década de los 1990, cuando los buscadores que empezaban a surgir, como Altavista, Yahoo, Excite, Infoseek, Lycos o WebCrawler, se vieron como potenciales herramientas para saber cuál era la influencia de las páginas web, ya que unas citaban a las otras (Bar-Ilan & Peritz, 2001). Entonces, esta oportunidad de análisis quedó plenamente establecida a partir de la idea del PageRank de Google, se podía ver cómo el mundo académico, que utilizaba las citas como forma de reconocimiento de otros colegas, se reproducía en la web.

Una de las características que quería analizar la cibermetría era el grado de colaboración que existía entre ellos (Almind y Ingwersen, 1997). Esta disciplina describe, según Orduña y Aguillo (Orduña-Malea & Aguillo, 2014), la forma de analizar de forma objetiva la relación de las instituciones investigadoras desde su sitio web y hacia él. Estas relaciones muestran la distribución entre autores, documentos, instituciones, revistas o países, la detección de citas permitía ver las conexiones entre colegas, que antes permanecían invisibles (Bar-Ilan et al., 2012). Estos mapas son ahora una característica común en muchas de las herramientas de análisis de citas como: Web of Science, Dimensions o Wizdom.

Durante mucho tiempo los bibliómetras se movían en un medioambiente estable porque analizaban publicaciones en papel (Cronin, 2001), en el momento en el que la web empieza a ser una realidad y las revistas publican en electrónico, las herramientas bibliométricas que hasta ese momento controlaban se abren a una gran diversidad de posibilidades, aunque sin saber cómo controlarlas porque el crecimiento de internet es hoy en día inabarcable. Los indicadores web complementaban la información descrita por la estadística propuesta por la cienciometría y mostraba relaciones inesperadas, ya que la cobertura era mucho más amplia, el problema era que seguían utilizando técnicas utilizadas en las antiguas métricas (Aguillo, 2009).

La web permitía a los investigadores hacer algo más que publicar. La creación de blogs, por ejemplo, los llevaba a que pudiesen opinar de forma libre sobre su campo de investigación, algo que un artículo científico no permite hacer. De esa forma, esos enlaces a citas bibliográficas que tal vez no podían poner en esos artículos académicos, pero que eran de interés, aparecían y dejaban de estar escondidas entre la producción científica (Adie & Roe, 2013).

A este fin, como se verá en la metodología, hemos diseñado una ecuación de búsqueda que nos ha permitido seleccionar resultados de investigación cuando relacionan el concepto de bases de datos académicas y el concepto de comunicación académica. Y esto es lo que nos ha permitido ver cómo se relacionan e influyen entre ellos estos dos conceptos a los que nos hemos referido también en el título del trabajo.

1.1. Objetivo y preguntas de investigación

De acuerdo con lo señalado en el apartado precedente, el objetivo principal de este trabajo es desarrollar un estado de la cuestión sobre el uso e impacto de los buscadores académicos en la comunicación y difusión de la producción científica. A partir de este objetivo, la pregunta de investigación que nos formulamos es la siguiente:

• ¿Cuál es la visión que aporta la investigación académica sobre la relación de los principales sistemas de búsqueda y recuperación de información científica con la comunicación académica?

2. Marco teórico

En el contexto que nos ocupa, la comunicación académica se puede definir como el «ecosistema que produce, analiza, recoge y distribuye nuevo conocimiento científico y académico» (Anderson, 2020: 1).

En concreto, las revistas se crearon para poder formalizar la correspondencia entre académicos y que sus resultados llegasen a una audiencia más amplia, además, la publicación formal de un artículo se exige para acceder a un trabajo académico (Anderson, 2020: 1344). Además, sigue Anderson, los académicos se comunican porque desean que otros pares lean y citen lo que han escrito y el deseo de ser muy leído puede entrar en conflicto con la necesidad de ser publicado en una revista muy prestigiosa.

Definir la calidad académica es difícil porque tiene muchas dimensiones que se puede aplicar de diferentes formas dependiendo del contexto en el que se esté evaluando, también es difícil porque calidad y relevancia son dos criterios importantes, pero no describen las mismas variables (Abadal, 2017; Anderson, 2020: 79; Baiget y Moya Anegón, 2020).

Lo que se creó para saber qué revista elegir para que formase parte del fondo de una biblioteca especializada, el Science Citation Index (SCI), ha pasado a ser una herramienta indispensable para conocer cuál es el impacto que puede tener una revista y de esta manera extrapolar este impacto a los investigadores que publican en ellas. Esto ha recibido numerosas críticas cuando se utiliza el impacto de la revista para medir la calidad de la investigación, y ha sido duramente criticado en manifiestos como el DORA y el de Leiden (DORA, 2018; Hicks et al., 2015). Eugene Garfield acuñó el término impacto para medir diferentes niveles de atención (Singh et al., 2020). Pero el impacto a menudo se ha definido utilizando indicadores para que fuese un análisis más cuantitativo que cualitativo, esta visión hace que se pierda el fin último de esta medición y es la influencia que una investigación puede tener en la sociedad, centrándose únicamente en la parte económica de este impacto (Singh et al., 2020).

En realidad, la atención que genera un artículo no tiene por qué coincidir con el impacto que éste tiene, no deben ser sinónimos (Yang et al., 2021). Los investigadores generan su producción académica teniendo en cuenta a los que ya conocen ese campo (Anderson, 2020), así que lo esperable sería que otros autores usen esos artículos para sus propios estudios y los citen. La realidad es que, incluso desde el inicio del estudio de la cienciometría en los años 40 del siglo XX, se detectó que un 75% de los artículos estaban concentrados en los mismos autores (van Raan, 2019). El proceso de citación está basado en la construcción de una red, cada nodo es un artículo y los operadores de comunicación son las citas (Borku Uysal et al., 2021).

De hecho, el problema de basar un análisis bibliométrico en una sola herramienta es que no siempre se adapta a la tipología documental en la que se ha publicado el documento. Los Journal Citation Reports consideran que hay tipos de documentos no «citables» (Larivière y Sugimoto, 2019): editoriales, cartas y nuevos ítems. Los investigadores se comunican utilizando un amplio espectro de formatos, según el nivel de formalidad que quieran, toda la publicación académica es comunicación académica, pero solo alguna de esta comunicación es publicación formal (Anderson, 2020, 58-59). Se necesitan recursos alternativos para aquellos documentos que no están publicados en formato artículo, como son los ensayos clínicos, las patentes o si el artículo no está indizado en bases de datos conocidas (van Raan, 2019).

Teniendo en mente esto, parece al menos cuestionable que a la hora de calcular el factor de impacto (FI) de la revista, las citas utilizadas para calcularlo vendrán de todos los documentos «citables» y «no citables», pero se dividirán solo entre las citas de documentos «citables» para calcularlo (número de citas recibidas en un año por los artículos publicados en una revista los dos años anteriores / número de ítems citables de los dos años anteriores) (Anderson, 2020, p. 182; Larivière y Sugimoto, 2019).

Además, la inclusión de las autocitas puede producir un sesgo a la hora de calcular el FI, permitir muchas puede hacer dudar de la calidad de las revistas. En ocasiones, autores con una gran producción científica suelen autocitarse más, aunque se sabe que estas autocitas se dan más en las revistas con un FI más bajo (Larivière y Sugimoto, 2019).

A partir de 1979, la Universidad de Leiden comienza a asignar los fondos recibidos por el Ministerio de educación no solo por el número de alumnos matriculados, sino también midiendo la calidad de la producción científica (Van Raan, 2019). Desde las instituciones, se empezó a promover el uso de herramientas bibliométricas para evaluar a sus investigadores. Esto provocó que se creara una dependencia muy importante hacia las revistas indizadas en las bases de datos de citas.

El sistema académico está formado por una serie de relaciones organizacionales e individuales complejas que pueden contribuir de diferentes formas en la producción científica y académica, y se da por hecho que estas relaciones son equitativas de diferentes formas (Anderson, 2020, p. 16). Este sistema académico está formado por los siguientes niveles (Anderson, 2020, p. 24):

1. Académicos y científicos.

2. Instituciones [que contratan a los investigadores].

3. Agencias de financiación.

4. Agencias gubernamentales.

5. Grupos de interés y lobistas.

6. Editoriales.

7. Editores y revisores.

8. Sociedades académicas y científicas.

9. Bibliotecas.

Muchos son los autores que han criticado esta evaluación durante estos años, como Isidro Aguillo en su perfil de Twitter. El propio Garfield señaló en muchas ocasiones que creó el SCI como herramienta de evaluación de las revistas por parte de las bibliotecas, para que sus responsables pudieran decidir cuáles eran las mejores revistas en las especialidades de su institución (Chubin y Garfield, 1980).

Además, el FI varía considerablemente según el campo, ya que las revistas de campos más populares, como las STEM, tienen mayor FI que otras que están en ciencias sociales o arte, lo cual no implica que en otras con menos FI haya menor actividad (Borku Uysal et al., 2021), y no se pueda utilizar como único valor de medición de calidad de una revista. Durante muchos años en España se utilizaba incorrectamente el “sumatorio” de FI, el cual pervertía su uso porque simplemente se sumaba el FI de las revistas donde los investigadores de una institución publicaban un artículo.

2.1. Críticas al uso del factor de impacto

¿Cuáles son los motivos de que el uso del FI sea controvertido? Hay una considerable bibliografía sobre el tema, pero Anderson resume de forma especialmente acertada los principales argumentos (Anderson, 2020, p. 183):

a) Un alto número de citas no son una medida de calidad académica o validez científica. Las citas son un indicador importante, pero por si solas no demuestran la calidad de la investigación.

b) Se cree que se puede manipular el FI porque viene determinado por las citas y porque éstas son relativamente fáciles de generar, por ejemplo, entre grupos de autores relacionados.

c) El FI mide el impacto de la revista, en cambio, se utiliza como un indicador de la calidad de los artículos publicados en ella. Es decir, la métrica se refiere a la revista y se utiliza para valorar la calidad del artículo.

d) Ha sido la necesidad de evaluar la investigación a nivel de autor e institución la que ha provocado que se pervierta este primer uso. La ventana de citación de un artículo en temática STEM es de dos años (Larivière y Sugimoto, 2019), por lo que se deberían tener en cuenta diferentes herramientas para la medición de la atención de un artículo y es útil para aquellos investigadores que llevan más tiempo generando una producción científica. Además, en buscadores académicos como Google Scholar (GS), el orden de los artículos viene por la cantidad de citas que tienen, aquellos más antiguos estarán situados en los primeros resultados (Condit Fagan, 2017; Martín-Martín et al., 2016).

e) El uso inadecuado del factor de impacto promueve entre los académicos una competición mediante la publicación en diferentes revistas con prestigio que tienen un FI que sea válido para la institución, normalmente los de los JCR (Anderson, 2020: 50, 186). Poder publicar un artículo en una revista considerada prestigiosa supone que esa autoridad se le dé por ende al autor (Anderson, 2020,. 62, 186). «Los investigadores cada vez más piensan en indicadores. Han sustituido el “gusto por la ciencia” por el “gusto por los ránquines”» (Larivière y Sugimoto, 2019).

f) Cuando se aprovechó la generalización del uso de internet para la difusión científica por parte de las revistas y estas pasaron a electrónico, fue mucho más fácil encontrar información científica e interrogar a las bases de datos para conocer las relaciones entre la producción académica (Anderson, 2020, p. 20).

g) El ecosistema académico que se ha creado con los años, está formado por microentornos en los que se ofrece a los académicos e investigadores que comparten intereses comunes en líneas de investigación determinados tanto oportunidades como nuevas complicaciones para poder destacar en su disciplina (Anderson, 2020: 29).

2.2. Los «nuevos» sistemas

Con el espíritu de crear una nueva herramienta para la evaluación académica se creó Scopus en 2004, unas semanas después de su lanzamiento también se presentó Google Scholar (GS) (Delgado López-Cózar et al., 2019). Estas dos herramientas añadieron al panorama de la cienciometría una nueva oportunidad para poder tener una visión más amplia del impacto de la producción académica.

Scopus es una base de datos bibliométrica que pertenece a la editorial Elsevier (Codina, 2019). Contiene más de 22.000 revistas publicadas por más de 5.000 editores internacionales. La cobertura bibliométrica empieza en 1996 e incluye patentes y webs integradas, así como métricas como la Scimago Journal Rank (SCR) y SNIP (Source-normalized impact paper) de la universidad de Leiden (FECYT, 2018). La ventaja de Scopus es que cubre más revistas de ciencias sociales y tiene una cobertura más amplia de revistas de habla no inglesa (Codina, 2019).

Scopus provocó que existiese una competencia directa con la WoS. Dos empresas con un mismo objetivo, conocer el impacto de los trabajos de los autores que publican en las revistas indizadas por estos recursos.

Por otro lado, GS permite hacer una búsqueda exhaustiva en la web sobre literatura académica gracias a una serie de bots que localizan recursos académicos. Se puede encontrar información sobre diferentes disciplinas y recursos: artículos, tesis, libros, resúmenes de congresos, etc. (Condit Fagan, 2017). Es un buscador académico muy utilizado para conocer las fuentes de citación y la comunicación académica (Borku Uysal et al., 2021).

Este recurso fue creado por Anurag Acharya y Alex Verstak, ingenieros de Google, en noviembre de 2004. Este recurso ha evolucionado desde sus inicios, ya que se fueron añadiendo editoriales y pudo rastrear más información bibliográfica. Las bases de datos conocidas hasta ese momento basan la información que recogen en un listado, principalmente de revistas, un pequeño número de revistas dan la mayoría de artículos que se recogen sobre un tema, GS representa una rotura de este paradigma ya que indiza toda la web incluyendo cada documento que encuentra (Delgado López-Cózar et al., 2019).

Las páginas de resultados se ordenan por relevancia, ahora bien, aunque no se sabe muy bien cuál, hay evidencia de que cuantas más citas reciba un artículo, más arriba estará en la lista. El motivo por el que los buscadores ocultan los detalles del cálculo de la relevancia es supuestamente evitar el spam (Rovira et al., 2018).

El año 2012 se pone en marcha el Google Scholar Metrics (GSM) (Gonzalez-Pardo et al., 2020). Es una forma de que los autores conozcan las citas de sus artículos. Se puede ver quién los ha citado, ver gráficos de citas durante el tiempo y contabilizar diferentes métricas de citas. Además, permite hacer un perfil público para que aparezca en los resultados de GS cuando alguien haga una búsqueda con el nombre del autor (Google Scholar, n.d.).

GSM es un híbrido entre información bibliográfica y bibliométrica que presenta un ranquin de revistas según sus indicadores bibliométricos cuyos indicadores son calculados utilizando los datos de citas de artículos que se han publicado recientemente en esas revistas. Las políticas de inclusión son (Delgado López-Cózar et al., 2019):

1. Solo las revistas que tienen al menos 100 citas en los últimos 5 años.

2. Cobertura: revistas, libros de congresos de informática e ingeniería eléctrica y repositorios preprint. Exclusión de libros y tesis.

3. Criterio de ordenación: por su índice-h5.

4. Categorización de los recursos: la primera variable es el idioma (existe un sesgo importante hacia los artículos en inglés (Rovira et al., 2021).

Los parámetros del ranquin de las revistas en GS son (Delgado López-Cózar et al., 2019):

1. Ponderación del texto completo de cada documento.

2. Dónde se ha publicado.

3. Quién lo ha escrito.

4. Cuántas veces se ha citado y si se ha hecho recientemente en otros artículos.

GS mantiene una serie de luces y sombras, como son el no proporcionar un listado de las editoriales, revistas, autores o materias incluidas, falta de estandarización, la irreproductibilidad de los datos y mezcla de tipologías documentales (Delgado López-Cózar et al., 2019; Orduña-Malea et al., 2016). GS cubre todos los territorios y comunidades, su objetivo es ser más inclusivo que otras herramientas como WoS o Scopus.

Las principales ventajas del GSM son (Orduña-Malea et al., 2016):

1. Mejorar la visibilidad e impacto de un autor.

2. Difundir las publicaciones científicas y otros trabajos académicos.

3. Conocer y dar a conocer algunos indicadores bibliométricos.

4. Saber quién cita, cuándo y qué documentos de un perfil.

5. Estar al día mediante la configuración de alertas personalizadas.

Una de las principales desventajas es su dificultad para poder realizar un análisis comparativo con otras herramientas, hay que utilizar programas complementarios, como Publish or Perish, que solo permiten descargar mil resultados y dejan seleccionar la tipología documental, así que, para hacer una comparativa de artículos, encontramos muchas referencias de resúmenes de congresos o libros, que harán que el número de resultados sea aún menor.

En enero de 2018 entra otra herramienta que va a ayudar a tener una imagen más completa del impacto de los artículos científicos: Dimensions, un producto producido por Digital Science, al igual que Altmetric, una de las más conocidas para medir el impacto social de los trabajos académicos.

Dimensions permite, de una forma visual, al igual que Altmetric con su “donut”, ver los datos de las citas que ha recibido una publicación. También nos da información del artículo, como el Field Citation Ratio (FCR) que muestra la influencia relativa en unas áreas específicas de investigación (Liu, 2018).

La información que nos da Dimensions es (‘Dimensions’, 2019):

a) Citas, las cuales se cuentan de todas las publicaciones que ha indizado Dimensions y que tienen la bibliografía que ha utilizado el artículo en abierto.

b) Citas recientes, las citas recibidas en los últimos dos años.

c) Field Citation Ratio (FCR)ç, que indica el rendimiento relativo de las citas, cuando se compara con artículos de esa “edad” dentro de la misma área. El FCR normalizado es de 1.0 para su selección de artículos. Un valor FCR de más de 1.0 muestra que la publicación tiene una media de citas más alta para su grupo.

d) Artículos de menos de dos años no tienen FCR. Un artículo con cero citas tiene un FCR de 0.

e) Relative Citation Ratio (RCR), se calcula de la misma forma que el FCR, pero limitado al área de investigación y no a la edad de la publicación.

Lo mejor de este recurso es, que incluso en la versión abierta, es una herramienta muy fuerte, tiene buenas opciones de búsqueda y está conectada con Altmetric, por lo que así podemos ver al mismo tiempo el impacto en redes sociales como las citas del artículo. Según algunas comparativas que se han realizado Dimensions recupera casi la misma información de los artículos que Scopus (Harzing, 2019).

Los recursos bibliométricos basados en la web pueden ser útiles para poder complementar las comerciales, pero siguen teniendo limitaciones (van Raan, 2019):

a) No todo está en línea, por lo que su impacto puede estar produciéndose sin estar registrado en la web.

b) Es bastante probable que se produzca un sesgo en la representación de los autores provenientes de países emergentes porque no están en formato en línea.

c) La mayoría de los buscadores comerciales no indizan todo, así que tampoco se puede garantizar que se encuentren todas las citas.

d) El sistema basado en citas puede ser manipulado.

e) Las citas no siempre son positivas, así que no se puede tomar como único parámetro para medir la calidad de la producción científica.

Figura 1. Evolución temporal de los buscadores académicos

Fuente: producción propia.

3. Materiales y métodos

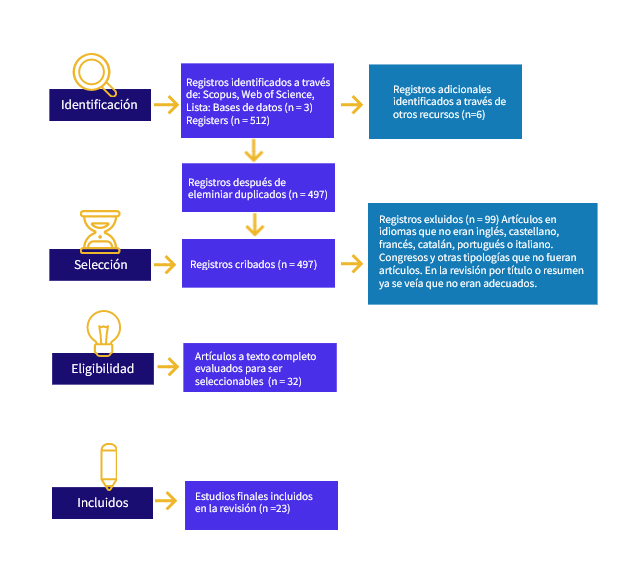

Esta scoping review se ha realizado aplicando el framework SALSA (Search, AppraisaL, Synthesis and Analysis) (Grant y Booth, 2009) y siguiendo el protocolo PRISMA para scoping reviews (Tricco et al., 2018).

Se eligieron la Web of Science y Scopus por ser las bases de datos bibliográficas académicas más conocidas para medir el número de citas recibidas por los investigadores españoles, y, para poder compararlos con otras plataformas académicas que también basaran su análisis en citas, se eligieron Google Scholar, Dimensions y The Lens.

A continuación, se detallan los criterios de inclusión y exclusión para seleccionar la base de la evidencia (los artículos que serán analizados) y otros aspectos de la metodología.

3.1. Criterios de inclusión y exclusión:

a) Inclusión

a. Artículos de investigación y artículos de revisión publicados en los últimos seis años.

b. Idiomas: inglés, español, catalán, francés, italiano y portugués.

c. Que sean reportes de investigación: estructura IMRyD o equivalente.

d. Artículos que incorporan análisis específicos en alguna de las bases de datos estudiadas en esta revisión: WoS, Scopus, Google Scholar, Dimensions, The Lens.

b) Exclusión

a. Documentos duplicados.

b. Documentos que no reporten trabajos de investigación.

c. Falsos positivos.

c) Fuentes utilizadas: WoS, Scopus y Lista.

4. Ecuaciones de búsqueda y número de resultados

La tabla siguiente muestra las ecuaciones de búsqueda de las bases de datos WoS, Scopus y Lista, incluidos los límites.

Tabla 1. Ecuaciones de búsqueda en WoS, Scopus y Lista

|

Base de datos |

Estrategia de búsqueda |

Resultados |

|

Web of Science |

(TI= ((WoS OR “web of science” OR scopus OR “google scholar”) AND (“scholarly communication” OR “academic publishing” OR “scholarly publication” OR “scientific communication”))) OR AB= ((WoS OR “web of science” OR scopus OR “google scholar”) AND (“scholarly communication” OR “academic publishing” OR “scholarly publication” OR “scientific communication”)) 2016-2021. English, Spanish, Portuguese |

42 |

|

Lista |

AB ((WoS OR “web of science” OR scopus OR “google scholar”) AND (“scholarly communication” OR “academic publishing” OR “scholarly publication” OR “scientific communication”)) OR TI ((WoS OR “web of science” OR scopus OR “google scholar”) AND (“scholarly communication” OR “academic publishing” OR “scholarly publication” OR “scientific communication”)) |

60 |

|

Lista |

TI ((dimensions OR lens OR “the lens”) AND (“scientific database” OR “academic database”)) OR AB ((dimensions OR lens OR “the lens”) AND (“scientific database” OR “academic database”)) |

0 |

|

Scopus |

(TITLE ((wos OR “web of science” OR scopus OR “google scholar”) AND (“scholarly communication” OR “academic publishing” OR “scholarly publication” OR “scientific communication”)) OR ABS ((wos OR “web of science” OR scopus OR “google scholar”) AND (“scholarly communication” OR “academic publishing” OR “scholarly publication” OR “scientific communication”))) AND (LIMIT-TO (PUBYEAR , 2021) OR LIMIT-TO (PUBYEAR, 2020) OR LIMIT-TO (PUBYEAR, 2019) OR LIMIT-TO ( PUBYEAR , 2018 ) OR LIMIT-TO (PUBYEAR, 2017) OR LIMIT-TO (PUBYEAR, 2016)) AND (LIMIT-TO (DOCTYPE, “ar”)) AND (LIMIT-TO (LANGUAGE, “English”) OR LIMIT-TO (LANGUAGE, “Spanish”) OR LIMIT-TO (LANGUAGE, “Portuguese”) OR LIMIT-TO (LANGUAGE, “catalan”)) |

182 |

|

Scopus |

(TITLE ((dimensions OR lens OR “the lens”) AND (“scientific database” OR “academic database”)) OR ABS ((dimensions OR lens OR “the lens”) AND (“scientific database” OR “academic database”))) AND (LIMIT-TO (PUBYEAR, 2021) OR LIMIT-TO (PUBYEAR, 2020) OR LIMIT-TO (PUBYEAR, 2019) OR LIMIT-TO (PUBYEAR, 2018) OR LIMIT-TO (PUBYEAR, 2017) OR LIMIT-TO (PUBYEAR, 2016)) AND (LIMIT-TO (DOCTYPE, “ar”)) AND ( LIMIT-TO (LANGUAGE, “English”) OR LIMIT-TO (LANGUAGE, “Spanish”) OR LIMIT-TO (LANGUAGE, “French”) OR LIMIT-TO (LANGUAGE, “Portuguese”)) |

38 |

Fuente: producción propia.

Como se puede ver, la ecuación anterior evita trabajos que solo mencionen uno de los dos temas que queremos relacionar, y de aquí que se conecten mediante un AND cada uno de los temas principales, comunicación académica, por un lado, y bases de datos, por otros, en ambos casos mediante conjunto de sinónimos documentales.

Selección de recursos de evidencia: Estado del proceso de selección de recursos de evidencia (screening, eligibilidad) incluidos en la scoping review.

Figura 2. Selección de recursos

Fuente: producción propia.

5. Resultados

En varios de los artículos seleccionados para esta revisión se reconoce a los artículos de revista como instrumento para la difusión de resultados en las diferentes disciplinas (Borku Uysal et al., 2021; Garcovich et al., 2020; Guallar et al., 2020; Lamba et al., 2020; Sun y Xia, 2016).

Existe desde hace tiempo un debate sobre si las citas son los mejores indicadores de calidad o impacto de los artículos (Mingers y Meyer, 2017). Los autores analizados señalan que se utiliza esta clase de bases de datos para llevar a cabo análisis bibliométricos (Borku Uysal et al., 2021; Martín-Martín et al., 2016), todas ellas nos dan información de las citas que han recibido los artículos en ellas indizadas, cada una de estas herramientas basa su análisis en diferentes revistas y niveles. Algunas investigaciones señalan, sin embargo, que tener acceso a estos recursos supone una carga económica importante para las universidades (Tsay et al., 2019).

Por otro lado, hay investigaciones, como la de Olmeda-Gómez y Perianes-Rodríguez (2019), que señalan el hecho de que, si solo tomamos las citas como consideración para conocer el impacto de una investigación, ignoraremos el contexto y por qué se citó el trabajo (Olmeda-Gómez y Perianes-Rodríguez, 2019). El análisis de citas da una información muy interesante sobre los descubrimientos de la comunicación académica y de los hallazgos científicos (Sun y Xia, 2016), pero su finalidad no era evaluar a nivel individual a las universidades o cualquier otra institución, se quería utilizar para medir la productividad de las áreas temáticas (Borku Uysal et al., 2021).

Al mismo tiempo, autores como Mingers y Meyer (2017) señalan que cada vez hay más interés por parte de las instituciones para que las investigaciones puedan ser medidas a cualquier nivel; interesa a nivel institucional y a nivel del autor (Mingers y Meyer, 2017). Martín-Martín confirma (2016) que cada año se publican más artículos que el año anterior, esto hace que se pueda producir una obsolescencia de la producción científica y controlar esto es muy difícil (Martín-Martín et al., 2016). Otros autores, como Condit (Condit Fagan, 2017) y Borrego (Borrego, 2020), explican que hay recursos, como GS, que dan importancia a los artículos más citados y que además dan acceso al texto completo (Condit Fagan, 2017), por lo que puede que sean más antiguos. A esto se le une que muchas bibliotecas han digitalizado sus fondos para facilitar su acceso (Borrego, 2020), por lo que esta infoxicación puede hacer que muchos de los artículos publicados anualmente no sean nunca citados y por tanto no sean mostrados en los ránquines de buscadores académicos. Seguramente, sería más justo que el crecimiento fuera exponencial y que artículos más recientes pudieran ser citados. Así como en la WoS o Scopus la relevancia viene dada por la fecha de publicación, en GS la da el número de citas (Martín-Martín et al., 2016) y en Dimensions se une además el valor de Altmetric. Las tendencias en investigación se mueven muy rápido si el campo de investigación es muy activo, como en salud o en ingeniería, en cambio en otras como en las humanidades o el arte la investigación es más estática (Borku Uysal et al., 2021).

Como explica Lamba (2020), desde la democratización del acceso a internet a finales de la década de 1990 principios del siglo XXI, la forma en la que los investigadores intercambian y manejan la información ha cambiado mucho (Lamba et al., 2020), lo que ha facilitado que aumente la importancia de las métricas alternativas como una forma complementaria de medir el impacto. Gracias a la web social y a las nuevas métricas, los investigadores tienen hoy en día nuevas opciones para respaldar un artículo publicado a través de una web o en las redes sociales (Garcovich et al., 2020).

Según Singh (2020):

La ˝atención˝ que un objeto de estudio recibe y el ˝impacto˝ que tiene este objeto no son sinónimos, las altmétricas miden la atención que los objetos de estudio reciben, esta atención puede ser buena o mala, las métricas basadas en las citas evalúan la atención académica. (Singh et al., 2020).

El panorama académico ha sufrido un gran cambio a la hora de realizar estudios bibliométricos, se han tenido que incluir las altmétricas para medir el impacto académico. Se ha producido un cambio en la forma de calcular pasando a unas métricas basadas en el uso web y social (Vkkm y Azeez, 2021), éstas miden cuánta o qué tipo de atención en línea se da a un artículo en las redes sociales y en la web (Garcovich et al., 2020).

Siguiendo con Singh (2020):

A menudo, el impacto se define más fácilmente utilizando indicadores [numéricos] que su concepto, pero se corre el riesgo de perder de vista lo que realmente se mide y lo que los investigadores pretenden medir, el impacto de la investigación implica dos categorías: el impacto académico y el impacto económico y social. (Singh et al., 2020)

Los indicadores ofrecidos por las altmétricas dan una nueva perspectiva que va más allá de la investigación por sí misma (Chi et al., 2019), dan datos similares sobre la compartición de un documento como pueden ser los tweets y las noticias donde se ha publicado información de ese artículo; pero hay otros datos que difieren, como son las descargas, las citas o las veces que se han añadido a un gestor bibliográfico. Hay que tener siempre en mente que son todos datos complementarios, esta información completa la imagen que podemos tener de ese artículo y que no solo viene basada en citas de otros recursos anteriores como WoS o Scopus (Garcovich et al., 2020; Singh et al., 2020) y estos datos permiten a la comunidad académica poder conectar con otros pares (Vkkm y Azeez, 2021).

Tal vez, una multiconexión con todas las plataformas sería lo más útil para poder tener controlado el impacto global de un artículo. Para tener un buen número de citas en un artículo éste debe estar publicado en una buena revista, estar disponible en varias bases de datos, que tenga una publicación temprana y que los autores tengan un buen índice h (Borku Uysal et al., 2021).

Las críticas a las altmétricas, según varios de los autores de este análisis, se basan siempre en la dificultad para poder controlar la información que recogen, se puede tener una serie de consideraciones a la hora de utilizarlas para poder medir el impacto de un artículo (Olmeda-Gómez y Perianes-Rodríguez, 2019):

1. Son un complemento de los indicadores basados en citas, sin capacidad de reemplazarlos.

2. Se dice que es fácil que puedan manipularse gracias a la creación de perfiles falsos en redes sociales o duplicidad de entradas en buscadores como GS.

3. No suele existir correlación con los indicadores bibliométricos, a pesar de que hay estudios que señalan que, a mayor puntuación en métricas alternativas, mayor número de citas a medio plazo (Singh et al., 2020).

4. Se incluyen datos que proceden de las redes sociales poco interesados en resultados de investigación, pero sí en temas de moda o populares.

5. No se ha consensuado lo que miden los indicadores que ofrecen las métricas alternativas.

En el caso de WoS y Scopus, analizan los artículos publicados en un conjunto de revistas que estos recursos indizan y controlan, por lo que podemos saber cuáles son (Gonzalez-Pardo et al., 2020; Mingers y Meyer, 2017; Tsay et al., 2019), mientras que GS y Dimensions consultan en la web (Gonzalez-Pardo et al., 2020; Martín-Martín et al., 2016), buscan la bibliografía en los artículos que la tienen en abierto. Por un lado, esto permite tener una fotografía más amplia del impacto del artículo (Vkkm y Azeez, 2021), pero por otro no controlamos cuáles está analizando y puede hacer que la búsqueda sea irreproducible porque alguno de los documentos localizados puede desaparecer (Condit Fagan, 2017; Singh et al., 2020). La mayoría de estudios muestran que la cobertura de GS es igual o superior a otros buscadores, pero igualmente se deben tener en cuenta WoS o Scopus para completar la información (Condit Fagan, 2017).

En cualquier análisis que se realice, vamos a tener que intentar abarcar el máximo posible de recursos ya que cada uno de ellos tendrá una limitación de cobertura, muchas referencias no las encontramos en todos los buscadores académicos (Gusenbauer, 2022; Tsay et al., 2019). En el caso de WoS tiene un 1,5% de unicidad en comparación con GS, pero si lo comparamos con otros tiene un 43-49% de unicidad; Scopus presenta un 14,9% de unicidad en comparación con WoS, y si se compara con GS tiene un 1,5-8,6% de unicidad. GS, en comparación con WoS y Scopus, tiene una unicidad de sus contenidos del 1,53% y 1.45%.

El público general normalmente no buscará información en buscadores académicos, pero dependiendo de la información que necesiten de alguna forma acabarán en GS, sobre todo si son libros. En cambio, para los estudiantes e investigadores, es algo muy común acabar utilizando GS ya que confían en la información que recuperarán en este recurso (Condit Fagan, 2017). Hay que tener en cuenta que la cobertura de la WoS y Scopus incluye muy poca información sobre libros, y la cobertura temática es limitada, mientras que, para materias de ciencias sociales, artes y humanidades, GS tiene una cobertura mucho más amplia (Borrego, 2020; Mingers y Meyer, 2017), investigadores de estos campos irán directamente a GS para encontrar la información que necesitan. En 2016 se permitió a Google que hiciera copias de libros para poder indizarlos sin pagar copyright a las editoriales, así que se le dio una oportunidad más para ampliar sus contenidos(Condit Fagan, 2017).

Uno de los sesgos que podemos encontrar en todos los buscadores académicos es el del idioma y el de la temática. La mayoría destacan los artículos en inglés (Condit Fagan, 2017; Martín-Martín et al., 2016). Se calculó que en 2014 había indizados en GS 114 millones de documentos en Inglés (Condit Fagan, 2017). La mayoría de los documentos indizados son de áreas temáticas STEM, ni siquiera GS mejora la presencia de materias de ciencias sociales y humanidades (Singh et al., 2020). Hoy en día se cita mucho más gracias a la facilidad de acceso a la información y a que muchas veces se tiene que citar artículos que no son necesariamente de la disciplina en la que se mueve el investigador (Sun y Xia, 2016), de ahí la importancia de que todas las materias estén bien representadas en los buscadores académicos.

La creación en 2015 de las Emerging Scources Citation Index (ESCI) en WoS, para incorporar la información de las revistas que se están evaluando para ser incluidas en la WoS Core Collections, un limbo en el que quedan las revistas hasta que entran en la WoS, y que supuso una diferenciación frente a Scopus (Gonzalez-Pardo et al., 2020), ha mejorado un poco la presencia de otras áreas e idiomas. La creación de Scopus permitió la ampliación de las revistas indizadas y por lo menos mejoró la cobertura ya que muchas revistas de países latinoamericanos fueron incluidas, así aumentaron el número de revistas no angloparlantes (Gonzalez-Pardo et al., 2020).

Condit nos explica cómo algunos estudios critican los datos que da GS por ser desordenados en la recogida automática (Condit Fagan, 2017):

a) Identificación incorrecta del título.

b) Autores mal asignados o eliminados.

c) Revisiones de libros que han sido indizadas como libros.

d) Fallo al agrupar versiones del mismo documento, lo que hace que las citas suban.

e) Agrupación de diferentes ediciones de libros, lo cual hace que baje el número de citas.

f) Atribución de citas a documentos que no los han citado o pérdida de citas que sí existen.

g) Duplicación de perfiles de autores.

h) Para recuperar información en idiomas diferentes al inglés se tendrá que hacer en cada uno de los idiomas que se quieran recuperar.

i) Aunque GS recoge información sobre literatura gris ésta no suele aparecer en posiciones altas en los resultados.

A pesar de esto, muchos autores incluyen GS como recurso consultado para realizar revisiones sistemáticas, aunque no se pueda reproducir la búsqueda y el límite de descarga a través de la herramienta Publish or Perish se limite a mil resultados cada vez (Condit Fagan, 2017).

Figura 3. Cuadro comparativo de los buscadores académicos

Fuente: elaboración propia.

6. Discusión

Durante muchos años hemos dependido de indicadores como el factor de impacto para realizar juicios sobre la calidad de las revistas, aunque cada vez los investigadores son más conscientes de que no es el único, ni necesariamente el mejor sistema de evaluación. No obstante, se sigue utilizando por su facilidad. Es un dato simple que proporcionan las bases de datos y muchas agencias de evaluación encuentran en el uso de estos indicadores una forma de evitar análisis cualitativos más costosos, como sería el análisis cualitativo de las investigaciones en sí mismas.

En estos últimos años, sobre todo desde 2010 con la aparición de las métricas alternativas, han surgido varias iniciativas como la Declaración de San Francisco DORA (Aguillo, 2015), en la que reclaman que no se evalúe la calidad de la producción científica basándose únicamente en criterios centrados en indicadores cuantitativos como el factor de impacto o el índice h. La idea de estas declaraciones es que usar estos indicadores solamente es una forma de renunciar a hacer evaluaciones mediante decisiones informadas. Es, por tanto, una forma de irresponsabilidad de los evaluadores.

Además, hemos de tener en cuenta que, en el caso de países no anglosajones, el idioma va a ser castigado a la hora de posicionar una publicación, la mayoría de estos buscadores visibilizan más aquellas publicaciones en inglés frente a otros idiomas (Rovira et al., 2021). Además, dan más visibilidad a aquellos publicados en revistas STEM frente a otras temáticas más relacionadas con las ciencias sociales, arte y humanidades.

Poco a poco, la comunidad investigadora va alzando la voz para que se tengan en cuenta criterios cualitativos (como el impact statement) aparte de los indicadores cuantitativos a nivel de revista. Ya en su momento, la entrada de Scopus supuso un cambio porque indizaba otras revistas que no estaban incluidas en la WoS, aunque mantiene los problemas atribuidos a los indicadores a nivel de revista. No obstante, al menos, vino a aportar otra fuente de información con la que se pueden completar los datos que aportan los JCR.

A continuación de la aparición de Scopus llegó GS, y se vio como una nueva herramienta que podría mejorar estas carencias, pero también tiene sus limitaciones, empezando por no saber qué está analizando hasta no poder descargar la información de más de 1000 referencias con un programa externo como Publish or Perish. Lo mismo pasó años después con Dimensions, que tampoco muestra de dónde está recogiendo la información. Se supone que estas dos herramientas tienen su base en toda aquella bibliografía que esté en abierto, y cada vez han ido aumentando la cantidad de información que se ha ido rastreando, pero es una de las mayores críticas que se les hace, no conocer los recursos que rastrean.

En el caso de The Lens podemos saber cuáles son los recursos donde recoge la información de las citas: Microsoft Academic (ya no está disponible), DOI, Pubmed, Core, PubMed Central y OpenAlex. Aunque también limita la cantidad de información que recupera, el límite no es tan rígido como puede ocurrir con la WoS y Scopus, que se limitan a las revistas que indizan.

Todas estas herramientas, además de otras que también nos dan una imagen de las citas detectadas, como Scite o Wizdom, y herramientas futuras, nos van a ayudar a conocer cuánta atención está recibiendo la producción científica de nuestros investigadores y sus instituciones.

7. Conclusiones

Esta scoping review tenía como objetivo principal responder la pregunta ¿Cuál es la visión de la investigación académica sobre los sistemas de búsqueda y recuperación de información de la producción científica?

Una de las principales conclusiones a la que podemos llegar cuando analizamos la bibliografía es que esta clase de herramientas deben complementarse entre ellas para poder tener una imagen completa de cuál es la situación de una publicación. Normalmente hablamos de artículos científicos porque hoy en día son los vectores más utilizados por los investigadores por su inmediatez en comparación con los libros o capítulos. Por tanto, creemos que las agencias de evaluación no deberían basar sus decisiones en un solo indicador o una sola fuente. Por el contrario, deben permitir a las personas evaluadas que aporten diversos indicadores de la calidad de su producción. Los evaluadores, por su parte, no deben hacer dejación de su responsabilidad utilizando solo indicadores cuantitativos, menos aún si son a nivel de revista, y aún menos si proceden de una sola fuente.

Esta imagen también debe cambiar según la disciplina de los investigadores, no será igual la ventana temporal que necesita un artículo de comunicación para ser citado que uno de medicina, por lo que este margen también deberá ser valorado, lo mismo que la edad investigadora de los autores.

Si lo que queremos es tener una imagen completa de la producción científica de una institución, se debe combinar diversas fuentes de información, como las que se han analizado en esta scoping review.

Por otro lado, los propios investigadores deben ir haciendo acopio de indicadores de su producción procedente de diversas fuentes. El gesto de ir añadiendo los artículos a nuestros perfiles investigadores como ORCID, Publons o GS o en nuestro gestor bibliográfico, como Mendeley o Zotero, nos va a quitar mucho trabajo posterior.

Como investigadores debemos tener en cuenta que en la institución hay departamentos que nos van a poder ayudar a tener esta imagen, como la biblioteca, así que no debemos dejar de apreciar este servicio para poder conocer y valorar la producción científica de la institución y de sus investigadores.

También hemos podido comprobar que las bases de datos y la publicación académica se influyen e interrelacionan en aspectos a veces tan esenciales como el índice de impacto u otros indicadores. Pero no solamente tenemos esta relación, sino que hemos podido examinar otras formas de influencia recíproca.

Como limitaciones de esta investigación cabe señalar que nos centramos en los sistemas de información académica que son, con diferencia, los más importantes, lo que ha dejado fuera a sistemas como The Lens, de modo que futuras investigaciones podrían ampliar el foco hacia este otro sistema, y, también, sería interesante llevar a cabo análisis comparativos sobre estas herramientas para conocer sus desempeños relativos.

Referencias bibliográficas

Abadal, E. (Ed.). (2017). Revistas científicas. Situación actual y retos de futuro. Ernest Abadal (ed.). Publicacions i Edicions de la Universitat de Barcelona.

Adie, E. & Roe, W. (2013). Altmetric: enriching scholarly content with article-level discussion and metrics. Learned Publishing, 26(1), 11-17. doi.org/10.1087/20130103

Aguillo, I. (2009). Measuring the institution’s footprint in the web. Library Hi Tech, 27(4), 540-556. doi.org/10.1108/073788309

Aguillo, I. (2015). La Declaración de San Francisco (DORA) y la mala bibliometría. Anuario ThinkEPI, 9(0), 183. doi.org/10.3145/thinkepi.2015.43

Almind, T.C. & Ingwersen, P. (1997). Informetric analyses on the world wide web: methodological approaches to ‘webometrics’. Journal of Documentation, 53(4), 404-426. doi.org/10.1108/EUM0000000007205

Anderson, R. (2020). Scholarly Communication. In Scholarly Communication. Oxford University Press. doi.org/10.1093/wentk/9780190639440.001.0001

Baiget, T. y De Moya Anegón, F. (2020). Manual SCImago de revistas científicas.

Bar-Ilan, J.; Haustein, S.; Peters, I.; Priem, J.; Shema, H. & Terliesner, J. (2012). Beyond citations: Scholars’ visibility on the social Web.

Bar-Ilan, J. & Peritz, B.C. (2001). Informetric theories and methods for exploring the internet: An analytical survey of recent research literature. Library Trends, 50(3), 371-392.

Borku Uysal, B.; Islamoglu, M.S.; Koc, S.; Karadag, M. & Dokur, M. (2021). Most notable 100 articles of COVID-19: an Altmetric study based on bibliometric analysis. Irish Journal of Medical Science, 190(4), 1335-1341. doi.org/10.1007/s11845-020-02460-8

Borrego, Á. (2020). Measuring the impact of digital heritage collections using google scholar. Information Technology and Libraries, 39(2). doi.org/10.6017/ITAL.V39I2.12053

Burghardt, K.J.; Howlett, B.H.; Khoury, A.S.; Fern, S.M. & Burghardt, P.R. (2020). Three commonly utilized scholarly databases and a social network site provide different, but related, metrics of pharmacy faculty publication. Publications, 8(2). doi.org/10.3390/PUBLICATIONS8020018

Chi, P.-S.; Gorraiz, J. & Glänzel, W. (2019). Comparing capture, usage and citation indicators: an altmetric

analysis of journal papers in chemistry disciplines. Scientometrics, 120(3),

1461-1473.

doi.org/10.1007/s11192-019-03168-y

Chubin, D. & Garfield, E. (1980). Is citation analysis a legitimate evaluation tool? Scientometrics, 2(1), 91-94. doi.org/10.1007/BF02016602

Codina, L. (2019). Scopus: caracterización y guía de uso avanzado · Preparación, búsqueda y exportación de resultados.

Condit Fagan, J. (2017). An Evidence-Based Review of Academic Web Search Engines, 2014-2016: Implications for Librarians’ Practice and Research Agenda. Information Technology & Libraries, 36(2), 7-47. doi.org/10.6017/ital.v36i2.9718

Cronin, B. (2001). Bibliometrics and beyond: some thoughts on web-based citation analysis. Journal of Information Science, 27(1), 1-7. doi.org/10.1177/016555150102700101

Delgado López-Cózar, E.; Orduña-Malea, E. & Martín-Martín, A. (2019). Google

Scholar as a Data Source for Research Assessment. In Handbook of Science and

Technology Indicators (95-127).

doi.org/10.1007/978-3-030-02511-3_4

Dimensions. (2019). Journal of the Canadian Health Libraries Association / Journal de l’Association Des Bibliothèques de La Santé Du Canada, 40(1), 23-26. doi.org/10.29173/jchla29405

DORA. (2018). San Francisco Declaration on Research Assessment. https://sfdora.org/read/

FECYT. (2018). Scopus. https://www.fecyt.es/es/recurso/scopus

Garcovich, D.; Zhou Wu, A.; Sánchez

Súcar, A.-M. & Adobes Martin, M. (2020). The online attention to

orthodontic research: an Altmetric analysis of the orthodontic journals indexed

in the journal citation reports from 2014 to 2018. Progress in

Orthodontics, 21(1).

doi.org/10.1186/s40510-020-00332-6

González-Pardo, R.; Repiso, R. y Arroyave-Cabrera, J. (2020). Revistas iberoamericanas de comunicación a través de las bases de datos Latindex, Dialnet, DOAJ, Scopus, AHCI, SSCI, REDIB, MIAR, ESCI y Google Scholar Metrics. Revista Española de Documentación Científica, 43(4), 1-16. doi.org/10.3989/redc.2020.4.1732

Google Scholar (n.d.). About Google Scholar. Retrieved 28 April 2022, from https://scholar.google.com/intl/en-US/scholar/about.html

Grant, M.J. & Booth, A. (2009). A typology of reviews: an analysis of 14 review types and associated methodologies. Health Information & Libraries Journal, 26(2), 91-108. doi.org/10.1111/J.1471-1842.2009.00848.X

Guallar, J.; López-Robles, J.-R.; Abadal, E.; Gamboa Rosales, N.-K. y Cobo, M.-J. (2020). Revistas españolas de Documentación en Web of Science: análisis bibliométrico y evolución temática de 2015 a 2019. El Profesional de La Informacion, 29(6), 1-27. doi.org/10.3145/epi.2020.nov.06

Gusenbauer, M. (2022). Search where you will find most: Comparing the disciplinary coverage of 56 bibliographic databases. In Scientometrics (Vol. 127, Issue 5). Springer International Publishing. doi.org/10.1007/s11192-022-04289-7

Harzing, A.-W. (2019). Two new kids

on the block: How do Crossref and Dimensions compare with Google Scholar,

Microsoft Academic, Scopus and the Web of Science? Scientometrics, 1-9.

doi.org/10.1007/s11192-019-03114-y

Hicks, D.; Wouters, P.; Waltman, L.; Rijcke, S., y Rafols, I. (2015). El Manifiesto de Leiden sobre indicadores de investigación. CTS: Revista Iberoamericana de Ciencia, Tecnología y Sociedad, 10(29), 275-280.

Lamba, M.; Kashyap, N. & Margam, M. (2020). Research evaluation of computer science publications using Altmetrics: a cohort study of Indian Central Universities. Global Knowledge, Memory and Communication, 70(4-5), 459-486. doi.org/10.1108/GKMC-07-2020-0097

Larivière, V. & Sugimoto, C.R. (2019). The journal impact factor: A brief history, critique, and discussion of adverse effects. Springer Handbooks, 2018, 3-24. doi.org/10.1007/978-3-030-02511-3_1

Martín-Martín, A.; Orduna-Malea, E.; Ayllón, J. & Delgado López-Cózar, E. (2016). Back to the past: on the shoulders of an academic search engine giant. In Scientometrics (Vol. 107, Issue 3, 1477-1487). doi.org/10.1007/s11192-016-1917-2

Mingers, J. & Meyer, M. (2017). Normalizing Google Scholar data for use in research evaluation. Scientometrics, 112(2), 1111-1121. doi.org/10.1007/s11192-017-2415-x

Olmeda-Gómez, C. y Perianes-Rodríguez, A. (2019). Altmetría como especialidad de investigación (Dimensions, 2005-2018). El Profesional de La Información, 28(6). doi.org/10.3145/epi.2019.nov.08

Orduña-Malea, E. y Aguillo, I.F. (2014). Cibermetría. Midiendo el espacio red. Editorial UOC - El profesional de la información.

Orduña-Malea, E.; Martín-Martín, A. y Delgado-López-Cózar, E. (2016). La bibliometría que viene: ALMetrics (Author Level Metrics) y las múltiples caras del impacto de un autor. El Profesional de La Información, 25(3), 485-496. doi.org/10.3145/epi.2016.may.18

Rovira, C.; Codina, L. y Lopezosa, C. (2021). Language Bias in the Google Scholar Ranking Algorithm. Future Internet, 13(2), 31. doi.org/10.3390/fi13020031

Rovira, C.; Guerrero-Solé, F. y Codina, L. (2018). Las citas recibidas como principal factor de posicionamiento SEO en la ordenación de resultados de Google Scholar. El Profesional de La Información, 27(3), 559. doi.org/10.3145/epi.2018.may.09

Singh, P.; Piryani, R.; Singh, V.K. & Pinto, D. (2020). Revisiting subject classification in academic databases: A comparison of the classification accuracy of Web of Science, Scopus and Dimensions. Journal of Intelligent & Fuzzy Systems, 39(2), 2471-2476. doi.org/10.3233/JIFS-179906

Sun, Y. & Xia, B. (2016). The scholarly communication of economic knowledge: a citation analysis of Google Scholar. Scientometrics, 109(3), 1965-1978. doi.org/10.1007/s11192-016-2140-x

Tsay, M.; Tseng, Y. & Wu, T. (2019). Comprehensiveness and uniqueness of commercial databases and open access systems. Scientometrics, 121(3), 1323-1338. doi.org/10.1007/s11192-019-03252-3

Van Raan, A. (2019). Measuring Science: Basic Principles and Application of Advanced Bibliometrics. In Springer Handbooks (237-280). Springer, Cham. doi.org/10.1007/978-3-030-02511-3_10

Vkkm, H. & Azeez, A. (2021). Impact of Scholarly Articles on Social media: An Altmetric Mapping of University of Calicut, Kerala-India. Library Philosophy and Practice, 2021(April), 1-19.

Wilder, E.I. & Walters, W.H. (2021). Using conventional bibliographic databases for social science research: Web of science and scopus are not the only options. Scholarly Assessment Reports, 3(1). doi.org/10.29024/sar.36

Yang, S.; Zheng, M.; Yu, Y. & Wolfram, D. (2021). Are Altmetric.com scores effective for research impact evaluation in the social sciences and humanities? Journal of Informetrics, 15(1), 101120. doi.org/10.1016/j.joi.2020.101120